L’analyse systémique consiste à considérer le cadre professionnel, les circonstances de l’accident, les facteurs humains et les défenses comme un ensemble fonctionnel cohérent [18,19]. Les rapports d’accidents aéronautiques, ferroviaires ou médicaux mettent bien évidence que tous ces accidents sont multifactoriels. L’accident aigu est souvent le révélateur de dysfonctions chroniques. En anesthésie, par exemple, on dénombre en moyenne 3.3 facteurs indépendants par décès [14]. Ils se répartissent de la manière suivante [4].

Facteurs organisationnels et institutionnels (53% des cas) : gestion économique serrée, restriction de personnel, culture locale laxiste ;

- Environnement de travail (44%) : équipement inadéquat, pressions hiérarchiques, horaires contraignants ;

- Facteurs humains (51%) : inexpérience, incompétence, erreur de jugement, défaut de vigilance ;

- Facteurs liés à l’équipe (62%) : défaut de communication ou d’entraide au sein de l’équipe, mésentente, remplacement du personnel en cours d'intervention ;

- Echecs techniques : 26% des cas.

Le facteur le moins problématique est l’état du patient, puisqu’il n’intervient que dans 7% des cas [14]. Dans le cadre du bloc opératoire, on peut regrouper les différents facteurs en jeu en cinq catégories.

Pathogènes organisationnels

Ce sont des facteurs latents situés en amont de l’évènement critique qui peuvent rester dormants pendant de longues périodes avant d’être révélés lorsqu’ils se combinent entre eux ou avec des défauts dans l’action d’un individu. Ils sont en cause dans 26% des accidents de salle d’opération [10,13,14]. Ces précurseurs de la catastrophe représentent le mode de fonctionnement de l’institution et son état d’esprit général [3,9,11,18,19,25].

Décisions managériales fondées sur des restrictions budgétaires ou des contraintes d’horaire, limitant le personnel engagé et les capacités fonctionnelles de l’individu.

- Organisation du service déficiente : manque d’encadrement ou de soutien par les aînés, mauvaise formation du personnel infirmier et médical.

- Manque de moyens, pauvreté des ressources ; dans certains hôpitaux africains, la mortalité liée à l’anesthésie voisine 1% des cas.

- Organisation suboptimale en salle d’opération : anesthésistes occupés simultanément en salle et en consultation, remises de cas fréquentes à cause de la limitation des horaires (35 heures en France, 50 heures en Suisse) ; à elles seules, ces deux situations doublent le risque d’accident [1].

- Culture locale laxiste, manque de rigueur dans l’esprit de l’institution.

- Normalisation des déviances: acceptation comme normales de conditions qui sont ordinairement considérées comme risquées.

La normalisation des déviances est un mécanisme majeur et sournois, sans responsable direct, mis en évidence après la catastrophe de la navette spatiale Challenger le 28 janvier 1986 [24]. Forts des leurs succès précédents, grisés par la course à la performance et pressés par les contraintes dans les fenêtres de lancement, les ingénieurs avaient donné le feu vert au décollage, malgré un froid intense auquel ils savaient que les joints des boosters résistaient mal; la navette a explosé 73 secondes après son envol. Les marqueurs de la performance d'une institution, comme le nombre de cas opérés, la rapidité des opérations ou la baisse du coût des interventions, peuvent effacer la sensibilité aux risques encourus, quand bien même ces derniers sont parfaitement connus. L’érosion progressive des marges de sécurité conduit à une situation à risque qui ne serait jamais tolérée si elle s’installait d’un seul coup. Tant qu’aucun accident ne survient, on a l’impression que le système peut tolérer les déviances et encaisser les à-coups sans broncher [17]. Le remplacement des anesthésistes en cours d'intervention pour respecter les durées de travail fait que celui qui réveille le patient n'est souvent pas celui qui l'a endormi; cette habitude ampute dramatiquement le sentiment de responsabilité et d'engagement vis-à-vis du malade. La banalisation des déviations par rapport à la bonne pratique et l'inertie des habitudes s'ajoutent au sentiment d’invincibilité pour masquer les situations qui enfreignent les règles de sécurité de manière répétitive. Noyée au milieu de nombreuses procédures et appuyée sur les résultats obtenus, cette normalisation des déviances passe inaperçue et n'est la faute de personne en particulier. Elle apparaît même à première vue comme une amélioration des performances du système, puisqu’elle permet d’augmenter le nombre de cas traités ou le confort du personnel, mais ne révèle ses dangers que lorsque la catastrophe survient. Elle est une forme de violation des règles de bonne conduite, qui est liée aux habitudes locales mais qui n’est pas ressentie comme une prise de risque vis-à-vis du patient, parce qu’elle apparaît comme une simple commodité, telle la mise des alarmes sous silence, la déconnexion de l’ECG et de la pression avant l’extubation, ou le transfert en salle de réveil avec un bloc neuromusculaire résiduel [2,17].

Facteurs liés à la situation

Ce sont les facteurs directement impliqués dans l’événement mais qui ne sont pas liés aux problèmes humains individuels ni à ceux de l’équipe [9,21].

- Pressions exercées par les contraintes d’horaire, par la gestion du bloc opératoire ou par les chirurgiens. Dans une enquête californienne, 49% des anesthésistes interrogés ont estimé avoir pris des décisions potentiellement dangereuses sous l'effet des pressions extérieures [22].

- Interruptions dans la gestion des activités, appels téléphoniques, demandes au sujet de cas différents.

- Distractions occasionnées par le va-et-vient du personnel, la présence d’observateurs et le bruit ambiant.

- Matériel inadéquat, défectueux, nouveau ou absent. L’ergonomie des blocs opératoires est souvent cauchemardesque car le matériel y est mal standardisé ; en chirurgie cardiaque, le sol est jonché de câbles ou de tuyaux allant dans tous les sens, et l’accès au malade est encombré de fils et de tubulures ("spaghetti syndrome").

- Préparation artisanale des médicaments en salle d’opération ; le taux d’erreur dans la préparation des médicaments est de 3% chez les infirmières et de 6.5% chez les médecins anesthésistes [7].

- Absence de routines claires et/ou de recommandations pour les situations difficiles, options divergentes parmi les cadres.

- Isolement de l’individu : les circonstances peuvent faire que l’anesthésiste se retrouve seul en salle lorsque survient un incident critique ; la présence de collaborateurs aurait empêché la situation d’évoluer vers l’accident.

- Changement d’anesthésiste : la personne présente en salle au moment d’un incident ne connaît pas le patient depuis le début de l’intervention et ne bénéficie pas de l’expérience d’épisodes précédents.

- Changement d’attribution des tâches : l’administration de l’héparine avant la CEC est du ressort du chirurgien dans certaines institutions et de l’anesthésiste dans d’autres ; les deux attitudes sont sûres, mais le passage de l’une à l’autre ne l’est pas. Lors d’une telle modification, une information soutenue doit être poussée auprès de tous les intervenants afin que chacun soit au courant de sa nouvelle tâche.

- Situations à risque, dites à couplage serré : cas techniquement difficile, chirurgie audacieuse, opération chez les vieillards ; ce sont des situations où le moindre incident conduit à un accident grave (single-fault condition), parce qu’il n’existe plus aucune marge de sécurité permettant d’absorber des fluctuations imprévues.

On distingue habituellement les situations à couplage lâche et les situations à couplage serré selon le degré avec lequel une action est reliée à ses conséquences [5,25]. Dans les premières, il existe suffisamment de redondance et de marge de sécurité pour qu’un événement malencontreux soit absorbé par les tampons naturels et les éléments correcteurs ; la déconnexion du circuit respiratoire au cours d’une intervention simple chez un patient ASA I entraîne une alarme bien audible chez un malade qui supporte parfaitement une apnée d’une minute. Par contre, la même déconnexion peut engendrer une catastrophe au cours d’un cas ASA IV qui désature très rapidement, dans un moment de tension avec beaucoup de bruit et tout le personnel occupé par des activités intenses, parce que l’alarme passe inaperçue ; cette situation est typique du couplage serré. Notre organisme jouit d’une grande tolérance face aux variations de son environnement et aux stress physiopathologiques (couplage lâche), mais la maladie et la vieillesse entament tellement ses réserves que la plus petite bévue peut devenir létale (couplage serré).

Facteurs liés à l’équipe

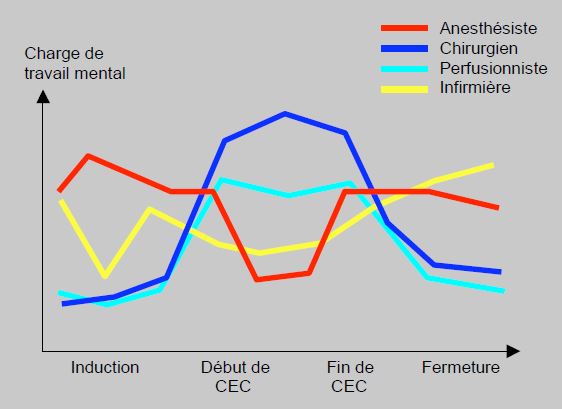

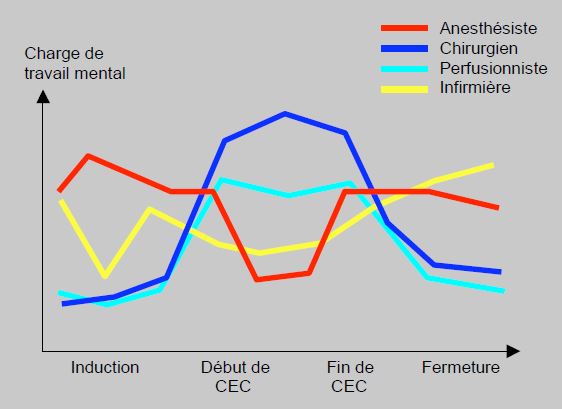

Une salle d’opération comprend un personnel divers qui ne forme pas forcément une équipe soudée ; les tensions interpersonnelles y sont fréquentes. D’autre part, les situations de stress ne sont ni identiques ni synchrones pour les chirurgiens et pour les anesthésistes (Figure 2.4) [26].

Figure 2.4 : Charge de travail mental (NASA Task Load Index) de différents acteurs au cours d’interventions de chirurgie cardiaque. L’intensité varie de façon réciproque entre chirurgiens et anesthésistes. Hormis le début de CEC et la sortie de pompe, les moments de stress ne sont pas synchrones, ce qui rend plus difficile la cohésion de l’équipe [d’après: Wadhera RK, Parker SH, Burkhart HM, et al. Is the "sterile cockpit" concept applicable to cardiovascular surgery critical intervals or critical events ? The impact of protocol-driven communication during cardiopulmonary bypass. J Thorac Cardiovasc Surg 2010; 139:312-9].

Le travail en équipe est fréquemment insatisfaisant pour plusieurs raisons [15].

- Défaut de communication entre anesthésistes ou entre chirurgien et anesthésiste ; la communication est impliquée dans 30-43% des incidents en médecine [16,25]. Elle commence avant l'opération avec la mise au point d'une stratégie commune entre chirurgiens, anesthésistes et intensivistes. La précision des informations est cruciale lors des remises de cas, mais sa pertinence est largement surestimée par les médecins [3]. Ce point est particulièrement important dans les institutions où la rigidité des horaires impose de changer d’anesthésiste en cours d’intervention.

- Relations excessivement hiérarchisées, au sein desquelles celui qui commande n’est malheureusement pas celui qui a la meilleure connaissance de la situation ; ceci s’accompagne d’une grande difficulté à formuler une remarque ou à proposer une correction face à un patron intimidant, quelle que soit sa fonction ou sa spécialité [27].

- Options thérapeutiques divergentes.

- Manque de soutien par les pairs.

- Mésentente au sein du groupe ; des accrochages surviennent en moyenne 11 fois au cours d’une intervention de chirurgie cardiaque [28].

Au sein d'un bloc opératoire, l'homogénéité des options thérapeutiques et la qualité de la communication deviennent d'autant plus importantes que les horaires du personnel médical et infirmier deviennent plus restrictifs, car le même patient est fréquemment géré successivement par deux équipes différentes [15]. D'autre part, les zones de surveillance intensive postopératoire sont de plus en plus indépendantes des anesthésistes de salle d'opération, ce qui implique également une communication très précise pour assurer la cohérence des soins.

Facteurs humains

Les facteurs humains ont déjà été mentionnés plus haut. En fait, l’individu est à la fois un facteur de risque et une défense. Même s’il dispose d’immenses connaissances et des dernières innovations techniques, il peut ruiner n’importe quelle intervention chirurgicale par une imprécision ou une négligence, la meilleure technologie ne valant que ce qu’en fait son utilisateur. Mais son attention, sa rigueur et son intelligence de la situation sont également les meilleurs gages de sécurité pour le patient.

Défenses

Les défenses sont la dernière parade avant l’accident. Elles sont d’autant plus importantes que tous les éléments précédents peuvent avoir des défaillances et que le système sans panne n’existe pas.

- Résistance physiologique de l’organisme aux agressions ;

- Ergonomie adéquate du matériel ;

- Alarmes des moniteurs ;

- Standards minimaux de sécurité ;

- Algorithmes pour les situations de crise discutés à l’avance et connus de tous ;

- Attitude de prudence et de vigilance de l’anesthésiste ;

- Contrôles croisés (double-check) par les membres de l'équipe;

- Contrôles constants des moniteurs, du système ventilatoire, de l’hémodynamique et du champ opératoire ;

- Correction immédiate des erreurs détectées ;

- Expérience accumulée au cours de la pratique clinique.

Les réductions de personnel pénalisent particulièrement ces défenses, car la majeure partie des erreurs faites par une personne en salle d'opération sont détectées par une autre [8].

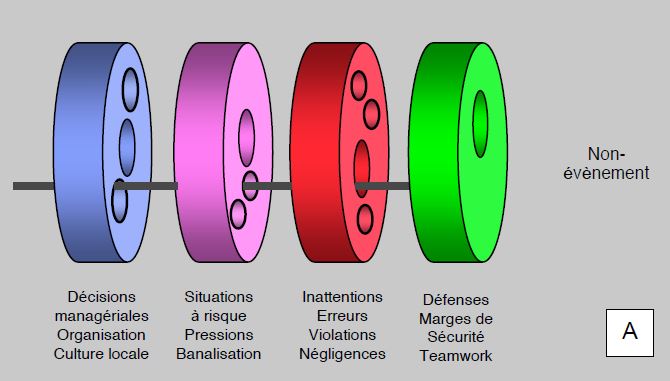

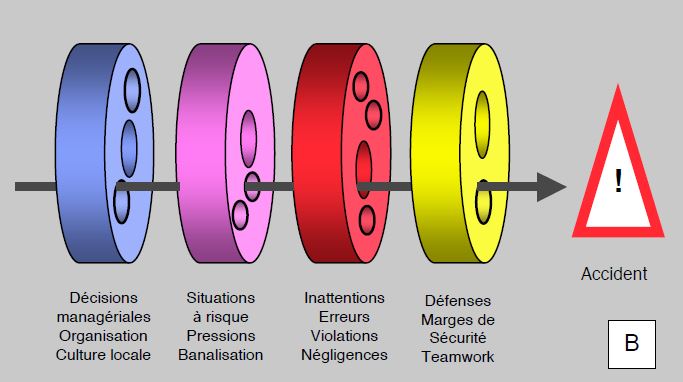

Modèle de J. Reason

Il serait erroné de ne considérer comme élément causal d’un accident que l’acteur qui est à l’extrémité d’une chaîne, laquelle comprend de multiples défectuosités. Le modèle du "fromage suisse" (swiss cheese) de J. Reason illustre le fait qu’un enchaînement de circonstances malheureuses et de défauts dans le système global puisse conduire à un accident si les mécanismes de défenses sont eux-mêmes défaillants [18,19]. Si, par un concours de circonstances, la trajectoire d’un événement se trouve en ligne avec les défauts du système, seules les défenses et les marges de sécurité peuvent bloquer l’évolution vers l’accident (Figure 2.5). Mais si ces dernières ont également des défauts simultanés, la catastrophe devient inévitable : à Tchernobyl, il a fallu trois erreurs successives dans la gestion d’un exercice pour conduire à l’explosion du réacteur n° 4 (26 avril 1986). Pour améliorer la sécurité du système, chaque niveau doit être l’objet du même degré d’attention, parce que des erreurs ou des négligences peuvent se produire à chacun de ces niveaux. J. Reason insiste sur le fait que son modèle ne représente qu'un instantané: contrairement à son image, le modèle est dynamique. Chaque individu doit donc contribuer à réduire la taille des trous.

Figure 2.5 : Illustration d’un enchaînement de causes conduisant à un accident, ou théorie du Swiss cheese de J. Reason. Des erreurs ou des négligences au niveau organisationnel (en bleu) et au niveau de l’environnement de travail (en violet), précèdent les facteurs individuels (en rouge). A: Si, par un concours de circonstances, la trajectoire d’un événement se trouve en ligne avec les défauts du système (trous dans les tranches de fromage), seules les défenses et les marges de sécurité peuvent bloquer l’évolution vers l’accident. B: Mais si ces dernières ont également des défauts simultanés portant sur la même trajectoire, la catastrophe devient inévitable. Pour améliorer la sécurité du système, chaque niveau doit être l’objet du même degré de surveillance. Bien que l'image soit figée, le modèle est dynamique: les disques tournent, les trous changent d'alignement et de taille ; de ce fait, un incident peut être sans conséquence à un moment donné, mais tourner à la catastrophe dans d’autres circonstances [d'après: Reason J. Human error: models and management. BMJ 2000; 320:768-70].

Les lois du chaos

Les mathématiques du chaos ont mis en évidence plusieurs données essentielles dans la gestion du risque [20,29].

- La survenue d’un événement inattendu dans un système complexe, comme un accident en cours d’opération, est le résultat d’un tel nombre de combinaisons possibles que sa prévision pose des problèmes insurmontables ; on peut certes en calculer la probabilité, mais jamais le moment ni le déroulement.

- La fréquence des évènements est inversement proportionnelle à leur gravité : les peccadilles sont courantes, mais les désastres sont rares.

- La multiplicité et l'interdépendance des éléments induit une causalité multifactorielle et non linéaire, accompagnée d'un délai de latence entre le premier déclencheur et le résultat final. La participation de plusieurs causes introduit un effet-seuil, en dessous duquel aucun phénomène macroscopique ne se développe mais au-dessus duquel apparaît une conséquence disproportionnée par rapport au déclencheur initial.

- Les systèmes complexes présentent un certain degré d’instabilité ; la causalité n’y est pas linéaire, mais dépend à chaque instant de multiples enchaînements et interdépendances. Une modification portant sur un seul petit élément peut conduire à la catastrophe au gré des étapes successives et des circonstances ultérieures (effet papillon) ; l’effet apparaît à distance de l’élément causal.

- A l'inverse, les systèmes complexes sont doués de résilience, qui est la capacité intrinsèque d'un système à retrouver spontanément son fonctionnement habituel après une période de déséquilibre.

Ces constatations signifient que les évènements graves sont par nature imprévisibles et peuvent survenir à tout instant : chaque cas peut se compliquer de manière inattendue. Une des clefs de la sécurité est de prévoir que la catastrophe est toujours possible. C’est le fondement de la loi de Murphy : si un système peut mal tourner, il le fera une fois. Cet adage est bien illustré par l’expérience du tas de sable. Si l’on verse du sable grain par grain sur un tas pendant suffisamment longtemps, on déclenchera fréquemment de petites avalanches, rarement des grandes, mais il arrive exceptionnellement que le tas soit suffisamment instable pour qu’un seul grain supplémentaire déclenche son effondrement. On ne peut jamais savoir si notre prochain pas ne sera pas celui qui déclenchera l’avalanche du siècle ; il vaut donc mieux avancer avec précaution. Nous ne pouvons ni connaître ni calculer toutes les conséquences possibles de nos actions. Tout ce que nous pouvons faire est d’agir de notre mieux au niveau local et immédiat [12]. Chaque détail mérite la même vigilance, non par perfectionnisme mais par réalisme : en effet, chaque petit geste peut être celui qui fait s’effondrer le tas de sable ou celui qui ouvre le passage à travers les tranches de swiss cheese jusqu’à l’enchaînement fatal : déplacer le défibrillateur ou ne pas remettre à leur place les seringues d’adrénaline peuvent retarder une réanimation au point de condamner le patient à un coma irréversible.

De même, le contexte à haut risque de la chirurgie cardiaque réclame une attention de chaque instant et une précision de chaque geste de la part de chacun, afin de prévenir au mieux ces enchaînements malheureux à partir d’incidents minimes mais corrigibles. Après un arrêt cardiaque, par exemple, on sait que ce sont les premières minutes qui comptent le plus pour la récupération. Il s’agit donc de ne pas les perdre à rechercher des palettes de défibrillateur dont on ignore la localisation, à préparer de la lidocaïne que l’on a oublié d’avoir à disposition, ou à téléphoner à un anesthésiste qui a momentanément quitté le bloc opératoire. Il est hors de doute que certains anesthésistes ont malheureusement des taux de complications supérieurs à d'autres! Il est bon de se souvenir que la qualité du travail a en général plus d'importance que la technique choisie [23]. Plus leur état est grave, moins les malades ont la capacité de corriger les déviations physiologiques, car ils ont perdu leur réserve fonctionnelle. La situation est si précaire qu'ils ne peuvent tolérer aucune déviance par rapport à leur fragile d'équilibre. L'anesthésiste doit donc veiller à corriger constamment les petites déviations qui s'installent. Même si elles semblent bénignes, leur accumulation conduira à la catastrophe. Une attitude proactive sur ce qui apparaît à première vue comme des détails est la condition du succès dans les systèmes complexes, que ce soit un malade, une centrale nucléaire ou un Etat: "Les catastrophes apparaissent de manière progressive quand, dans un système donné, se manifeste une petite perturbation qui ne rencontre aucune capacité de régulation, une toute petite perturbation qui n'appelait qu'une toute petite correction. En l'absence de capacité et de volonté d'agir, la première perturbation en rencontre une autre, tout aussi petite, qui ne trouve pas plus de réponse. Et les petites perturbations s'accumulent jusqu'à ce que le système perde la capacité de les réguler. C'est alors que survient la catastrophe" (Hugo Chavez, discours du 2 février 1999).

Malheureusement, il impossible de prouver l’efficacité des méthodes de précaution parce qu’elles reposent sur un enchaînement de cause à effet qui est inversé. Normalement, l’effet suit la cause ; dans le cas d’une mesure préventive, l’effet (la précaution) précède la cause (la catastrophe potentielle). Seule la survenue de la catastrophe peut prouver que la mesure de précaution aurait été utile. Il n’y en a aucune évidence avant son échec. Il n’y a définitivement pas moyen de fonder la précaution sur une evidence-based attitude puisqu’une prévention réussie est un non-évènement [6,25].

Bien qu’elles paraissent pédantes, ces remarques visent à souligner l’importance d’un état d’esprit fait d’exigence, de vigilance et de sécurité dans la conduite de l’anesthésie. Cette attitude est tout aussi nécessaire que les connaissances intellectuelles ou les performances techniques pour le succès de nos interventions. On peut penser qu’il est capital pour chaque anesthésiste de disposer d’une SvO2 continue ou d’une échocardiographie tridimensionnelle en salle d’opération. Pourtant, le plus important est qu’il soit là et qu’il soit attentif.

| Genèse des accidents |

|

Les accidents sont multifactoriels (3.3 facteurs indépendants en cause par décès lié à l’anesthésie). L’opérateur humain est à l’extrémité d’un enchaînement de situations et d’éléments différents qui ont généré les conditions de l’accident ; celui-ci survient par la combinaison de facteurs liés à l’organisation, à la situation, à la culture locale, à l’équipe et à l’anesthésiste.

L’ergonomie, les règles de sécurité, la vigilance et la prudence de l’individu forment des défenses efficaces.

Les accidents étant multifactoriels et imprévisibles, chaque geste peut être celui qui fonctionne comme le déclencheur de la catastrophe.

Dans les systèmes à risque comme un opération, chaque geste et chaque détail méritent la même attention car aucun n'est anodin.

|

© CHASSOT PG CLAVADETSCHER F Mars 2010, mise à jour Janvier 2012, Juillet 2017

Références

Références

- ARBOUS MS, MEURSING AE, VAN KLEEF JE, et al. Impact of anaesthesia management characteristics on severe morbidity and mortality. Anesthesiology 2005; 102:257-68

- BEATTY PCW, BEATTY SF. Anaesthetists’intentions to violate safety guidelines. Anaesthesia 2004; 59:528-40

- CHANG VY, ARORA VM, LEV-ARI S, et al. Interns overestimate the effectiveness of their hand-off communication. Pediatrics 2010; 125:491-6

- CLERGUE F. Sécurité anesthésique: de la gestion des erreurs à la gestion des risques. Conférence CHUV, 8 janvier 2009

- COOPER JB, NEWBOWER RS, LANG CD, et al. Preventable anesthesia mishaps: a study of human factors. Anesthesiology 1978; 49:399-406

- DUPUY JP. Pour un catastrophisme éclairé. Paris : Seuil, 2002

- GARNERIN P, PELLET-MEIER B, CHOPARD P, et al. Measuring human-error probabilities in drug preparation: a pilot simulation study. Eur J Clin Pharmacol 2007; 63:769-76

- GLAVIN RJ. Drug errors: consequences, mechanisms, and avoidance. Br J Anaesth 2010; 105:76-82

- GURSES AP, KIM G, MARTINEZ EA, et al. Identifying and categorizing patient safety hazards in cardiovascular operating rooms using an interdisciplinary approach: a multisite study. BMJ Qual Saf 2012; 21:810-8

- HALLER G, LAROCHE T, CLERGUE F. Morbidity in anaesthesia: Today and tomorrow. Best Pract Clin Res Anaesthesiol 2011; 25:123-32

- HELMREICH RL. Culture at work: national, organisational and professional influences. Aldershot:Ashgate, 1998

- KAUFMAN S. At home in the Universe. The search for the laws of self-organisation and complexity. New York, Oxford University Press, 1995

- LI G, WARNER M, LANG BH, et al. Epidemiology of anesthesia-related mortality in the United States, 1999-2005. Anesthesiology 2009; 110:759-65

- LIENHART A, AUROY Y, PEQUIGNOT F, et al. Survey of anesthesia-related mortality in France. Anesthesiology 2006 ; 105 :1087-97

- MAKARY MA, SEXTON JB, FREISCHLAG JA, et al. Operating room teamwork among physicians and nurses: teamwork in the eye of the beholder. J Am Coll Surg 2006; 202:746-52

- MANSER T. Teamwork and patient safety in dynamic domains of healthcare: a review of the literature. Acta Anaesthesiol Scand 2009; 53:143-51

- PRIELIPP RC, MANGRO M, MORELL RC, BRULL SJ. The normalization of deviance : do we (un)knowingly accept doing the wrong thing ? Anesth Analg 2010 ; 110 :1499-502

- REASON J. Safety in the operating theatre : Part 2. Human error and organisational failure. Qual Saf Health Care 2005 ; 14 :56-60

- REASON J. Human error: models and management. BMJ 2000; 320:768-70

- RUELLE D. Hasard et chaos. Paris: Odile Jacob, 1991

- SEXTON JB, THOMAS EJ, HELMREICH RL. Error, stress, and teamwork in medicine and aviation: cross sectional surveys. BMJ 2000; 320:745-9

- SINGER SJ, GABA DM, GEPPERT JJ, et al. The culture of safety: results of an organization-wide survey in 15 California hospitals. Qual Saf Health Care 2003; 12:112-8

- SLOGOFF S, KEATS AS. Randomized trial of primary anesthetic agents on outcome of coronary bypass operations. Anesthesiology 1989; 70:179-88

- VAUGHAN D. The Challenger launch decision: risk technology, culture and deviance at NASA. Chicago: The University of Chicago Press, 1997

- VON BEUZEKOM, BOER F, AKERBOOM S, HUDSON P. Patient safety: latent risk factors. Br J Anaesth 2010; 105: 52-9

- WADHERA RK, PARKER SH, BURKHART HM, et al. Is the "sterile cockpit" concept applicable to cardiovascular surgery critical intervals or critical events ? The impact of protocol-driven communication during cardiopulmonary bypass. J Thorac Cardiovasc Surg 2010; 139:312-9

- WAHR JA, PRAGER RL, ABERNATHY JH, et al. Patient safety in the cardiac operating room: human factors and teamwork: a scientific statement from the American Heart Association. Circulation 2013; 128:1139-69

- WIEGMANN DA, ELBARDISSI AW, DEARANI JA, et al. Disruption in surgical flow and their relationship to surgical errors: en exploratory investigation. Surgery 2007; 142:658-65

- ZWIRN HP. Les systèmes complexes. Mathématiques et biologie. Paris: Odile Jacob, 2006